EU Prozesse haben es an sich, so lang zu dauern, dass sie letztlich niemanden interessieren — und dann auch eher nerven als begeistern. Die DSGVO kippte vom Heilbringer, der Menschenrechte sichert, zur lästigen Bürokratie, die ihr Unwesen in vor sich hin staubenden Datenschutzprozessdokumentationen fristet, zu deren Erstellung auch Kleinunternehmen gezwungen wurden.

Meinungen zu Copyrightdebatten — wir erinnern uns an Ängste vor einem Meme-Verbot, nachdem Axel Voss neue Urheberrechtslinien durchgesetzt hatte, bewegen sich so schnell und abwechslungsreich zwischen gut und böse wie Kugeln im Flipperautomat.

Wird das jetzt anders, wo dem EU AI Act zumindest insofern Respekt gezollt wird, als er die erste demokratische und umfassende Regelung zu Künstlicher Intelligenz darstellt?

Der EU AI Act wurde lang diskutiert, neu aufgerollt, drohte an lokalen Kompetenzsimulationsgebärden vor allem aus Deutschlandund Österreich zu scheitern — und soll jetzt doch endlich in den nächsten zwei Jahren in nationalen Rechtsordnungen verankert werden.

Während es in den nächsten Monaten an die Umsetzung geht, habe ich noch einmal einen Blick zurück geworfen und vor allem die diversen Lobbying-Termine der EU-Abgeordneten während der heißen AI-Phasen unter die Lupe genommen.

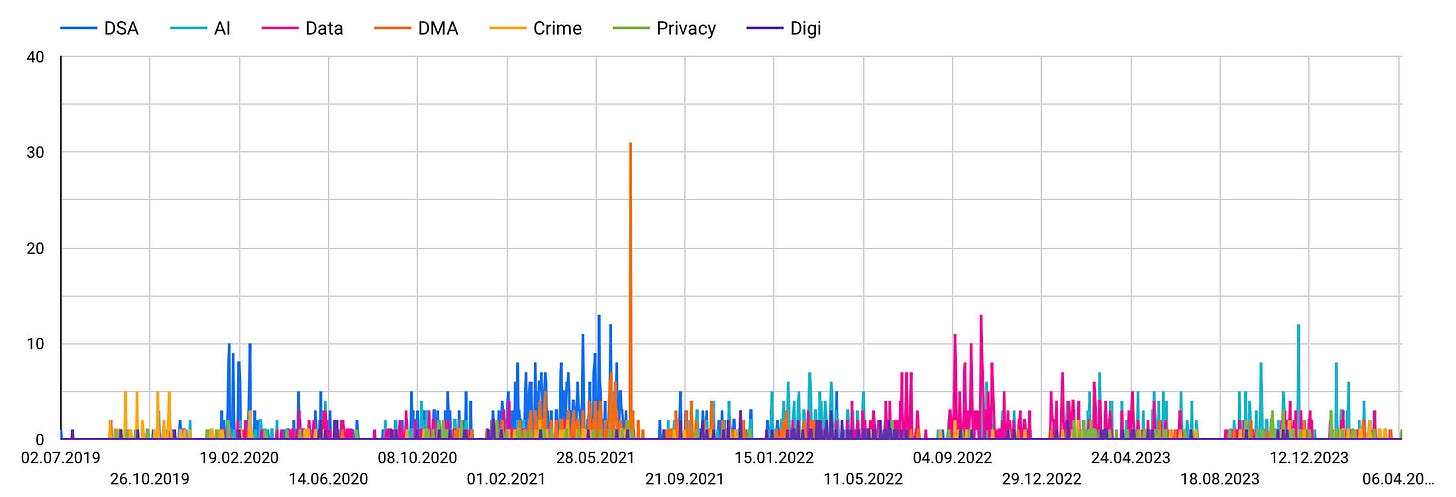

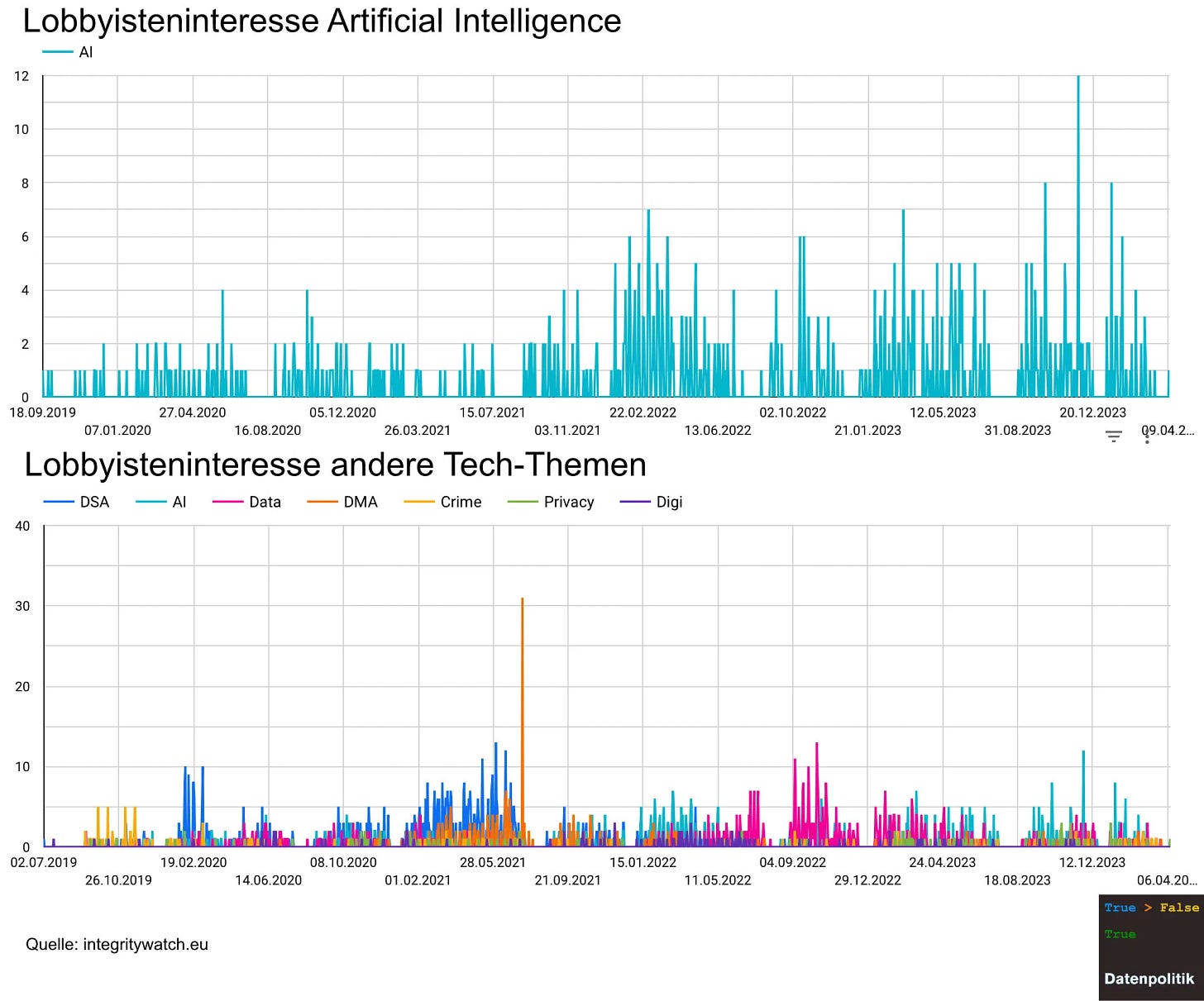

Die Eckdaten: In den vergangenen fünf Jahren haben die EU-Abgeordneten etwa 60.000 Termine dokumentiert. Rund 3.300 dieser Termine betreffen Themen aus dem Datenpolitik-Dunstkreis (AI, Digital Services, Digital Markets, Data, Cybersecurity). Knapp 900 Termine drehten sich um Künstliche Intelligenz.

Eine erste Hochkonjunktur hatte AI im Februar 2022, die intensivste Diskussionsphase war der Herbst 2023.

Beliebtester Gesprächspartner dabei war Axel Voss, der 170 dieser 900 Termine abwickelte, noch deutlich vor Dragos Tudorache (129) und Brando Benifei (66) den eigentlichen Berichterstattern zum EU AI Act. Während Voss schon seit 2020 zum Thema verhandelte, stiegen Tudorache und Benifei erst 2023 intensiver in das Thema ein.

Aktivster Lobbyist zum Thema war Google. Der Konzern wurde bei 30 Terminen mit 19 verschiedenen EU-Abgeordneten dokumentiert. Microsoft liegt mit 28 Terminen bei 20 Abgeordneten knapp dahinter. Facebook/Meta suchte 13 Mal das Gespräch, Amazon acht Mal, Apple gar nur drei Mal.

Österreichische EU-Abgeordnete waren wenig begehrte Gesprächspartner zum Thema Künstliche Intelligenz. Es sind nur zwei Termine mit dem SPÖ-Abgeordneten Hannes Heide verzeichnet.

Google und Microsoft führen bei allen Tech-Themen die Rankings der aktivsten Lobbyisten an, die politischen Interessen der Tech-Giganten sind dabei recht divers verteilt.

- Für Google war der Digital Services Act Priorität Nummer 1 — noch vor dem AI Act.

- Bei Microsoft ist das Verhältnis umgekehrt.

- Amazon hatte viel Diskussionsbedarf zum Digital Services Act und zu Data Act und Data Governance.

- Bei Apple stand dagegen ganz klar der Digital Markets Act im Vordergrund.

- Facebook diskutierte den Digital Services Act am intensivsten, gefolgt von Digital Markets Act und Privacy und Datenschutzthemen.

- Für OpenAI sind neun Lobbying-Termine dokumentiert, alle drehen sich um AI.

Der starke Fokus von Microsoft auf AI ist heute nicht mehr überraschend: Microsoft hat in den vergangenen Monaten massiv zugekauft — auch und gerade bei Unternehmen wie Mistral, die sich als europäische Alternative zu US-Tech empfohlen haben. Und mit dem Co-Pilot hat Microsoft eine möglicherweise massentaugliche AI-Integration im Rennen, die im Arbeitsalltag vieler Normalo-Officeanwender Fuß fassen könnte, sofern sie sich nicht doch als völlig nutzlos erweist. Anwenderberichte sind widersprüchlich.

AI Act — wann gilts?

Der AI Act wurde am 13.4. im EU Parlament beschlossen, die Veröffentlichung im Amtsblatt der EU steht wohl mit Mai oder Juni 2024 an. 20 Tage danach gilt der Act EU-weit. Damit beginnt eine bis zu dreijährige Übergangsfrist zu laufen. Sechs Monate nach dem Inkrafttreten sind KI-Anwendungen mit inakzeptablen Risiken verboten, 24 Monate danach gelten weitreichende Transparenzvorschriften, die für die meisten KI-Anwender auf Unternehmensseite die größten Veränderungen darstellen werden. Nach 36 Monaten müssen auch alle als riskant klassifizierten Systeme auf die strengeren Regeln ausgerichtet sein.

Risiken und Nebenwirkungen

Der Risikoklassifizierungsansatz des AI Act wurde öfters positiv erwähnt und ist ein sinnvoller Versuch, soziale Themen in technische Regelungen einfließen zu lassen, ohne auf die technische Natur des zu regelnden Gegenstands zu vergessen. Der Ansatz ist allemal besser als die Rufe nach Inhaltskontrolle oder Klarnamen, die sonst bei technischen Medienregulierungsdebatten oft ertönen.

In einer anderen Causa zeichnen sich allerdings Schattenseiten ab. Kindesmissbrauch ist zweifellos eine ganz und gar nicht wünschenswerte Hochrisikoangelegenheit, aber es ist eine ziemlich verrückte Idee, weitreichende Überwachungsbestimmungen im Zug von Regelungen zur Bekämpfung von Kindesmissbrauch einführen zu wollen.

Hier zeigt sich eine Schwäche des Risikoansatzes: Kindesmissbrauch ist schlecht — aber welche ursächliche Rille spielt Verschlüsselung bei der Entstehung des Problems oder des Risikos? Hier darf auch das Risiko einer hypertransparenten Kontrollgesellschaft nicht vernachlässigt werden — schon gar nicht, wenn gleich Ausnahmeregelungen für Polizei, Justiz und Politik geplant werden, aber nicht für Journalisten, Aktivisten oder NGOs.

Daten, Standards und politischer Relativismus

Wie standardisiert sind Standards? Für Sozialwissenschaftler, Historiker oder auch für Informatiker, die gewohnt sind, Prozesse auf verschiedenen Abstraktionslevels zu betrachten, ist das eine seltsame Frage. Natürlich sind Standards geschaffene Konventionen, die ihre Rolle nur eben dank dieser Eigenschaft erfüllen können. Standard zu sein ist keine Eigenschaft des Standards, sie kommt aus der Tatsache, dass der Standard als solcher akzeptiert wird.

Juristen, die so tun müssen, als wären Gesetze eben Gesetz (und nicht ebenso von Menschen geschaffene Konventionen), entdecken diesen Sachverhalt offenbar neu.

Hier ist eine interessante Arbeit einer Juristin an der UCLA, die die Frage der Relativität von AI Standards anhand bisher erarbeiteter Regelungen aus den USA, der EU und China untersucht.

Das Hauptproblem liegt dabei weniger in der Erarbeitung oder in der Nachvollziehbarkeit von Standards, sondern in ihrer Skalierbarkeit. Aus heutiger Sicht, so die Konklusio, gibt es keinen Weg, in einem politischen System etablierte Standards auch in einem anderen System sinnvoll durchzusetzen. Die mitwirkenden politischen Grundlagen sind zu unterschiedlich. Bei potenziell globalen Regelungen für globale Technologie ist das ein Problem. Der Streit um die Eigentümerstruktur bei TikTok ist dafür nur ein erster Vorbote.

Late to the Feudalismus-Party

Yannis Varoufakis hat ein neues Buch geschrieben. Fast 15 Jahre nach Jaron Laniers „You are not a Gadget“ entdeckt er den in dessen Buch beschriebenen Sachverhalt neu (naja, neu nicht wirklich) und nennt ihn Technofeudalismus: Wir alle sind Leibeigene, die die Ländereien der Tech-Giganten zu deren Vorteil bestellen und nichts davon haben. Naja.

Ich bin Journalist, Wissenschafts- und Technologiehistoriker,

Ich bin Journalist, Wissenschafts- und Technologiehistoriker,