Das Internet wird dümmer. Diese Diagnose begegnet aufmerksamen UserInnen zurzeit öfters – im Zusammenhang mit Desinformation und Clickbait, öfters aber auch vermehrt im Zusammenhang mit SEO und zuletzt in Hinblick auf KI.

Damit bekommt ein schon über Jahre gut eingeübter kulturkritischer Rant eine technische Untermauerung. Aber ist das tatsächlich die gleiche Diagnose?

Kulturkritik beklagt Tempo, mangelnde Reflexion, fehlendes Vorwissen, die Erosion kanonisierter Standards und inflationäre Autoritäten. Die technische Perspektive analysiert Zahlen und liefert Belege für fehlende Vielfalt. Suchmaschinenoptimierung war schon früh als Ausgrenzung und Einschränkung erkennbar. Wer sich nach Google richtete, hatte Glück. Inhalte, die zu selten gesucht wurden, verschwanden an den Rändern des Internet.

Jetzt gibt es dank einer Studie der Universität Leipzig Evidenz dafür dass Suchmaschinenoptimierung Suchen – und zwar alle, nicht nur Google – schlechter macht.

Kurz zusammen gefasst: Den größten SEO-Aufwand betreibt, wer mit Suchtraffic schnell Geld verdient. Das sind Affiliate-Anbieter, die auf ihren Webseiten nur kurze Produktbeschreibungen sammeln und dann zu Onlineshops weiterverlinken, die dafür bezahlen, dass sie verlinkt werden. Diese Seiten haben die höchsten Keyworddichten, die prägnantesten Headlines und die am besten kategorisierten Bilder. Und sie liefern sehr wenig Wert für User, die bei Testberichten, Userforen oder wenigstens den Shops besser aufgehoben wären. Gerade bei Produktsuchen verschlechtert das die Qualität der Suchergebnisse spürbar, so die Studie.

Habsburg oder Mann in Mond

Gute Suche ist aber nur ein Convenience-Thema. Schlechte Suche löscht gute Inhalte nicht aus, sie benachteiligt sie nur. Künstliche Intelligenz dagegen erzeugt Inhalte, die von Menschen verarbeitet werden und die von anderen künstlichen Intelligenzen herangezogen werden, um andere Inhalte zu erzeigen – bis Inhalte anhand von Inhalten erzeugt werden, die nichts mehr mit von Menschen generierten Inhalten zu tun haben.

Das zieht zwei wesentliche Probleme nach sich.

Zum einen wird KI dümmer. Künftige KI-Generationen trainieren sich an KI-generierten Inhalten, weil diese leichter verfügbar sind – und weil es in Zukunft weniger von Menschen generierte Inhalte geben wird. Ein einfaches Beispiel: Vor KI diskutierten Programmierer in diversen Foren über Lösungen für Software-Probleme. Davon lernt künstliche Intelligenz. Heute verfüttern sie halbfertige Codezeilen mit Fertigstellungsaufträgen an Künstliche Intelligenzen – und niemand erfährt davon, niemand lernt davon. Nicht einmal die KI.

Das zweite Problem ist allerdings noch wesentlicher. Künstliche Intelligenzen haben das Internet abgegrast, um zu lernen, ohne sich um Rechtefragen zu scheren. OpenAI trat als nonprofit-Forschungsprojekt auf, dann entstand zufällig eine kommerzielle Produktlinie. Andere bemühten sich nichteinmal um diesen Deckmantel. Jetzt zahlt Google 60 Millionen Dollar jährlich an Reddit, um dort generierte Inhalte zu Trainingszwecken nutzen zu können. Le Monde lizenziert Inhalte an OpenAI. Und kommerzielle KIs sind mittlerweile fortgeschritten genug, um Trainingsinhalte für die Ausbildung ihrer Folgegenerationen erstellen zu können. Die arrivierten Softwareanbieter haben also zwei Vorteile: Sie können Trainingsinhalte selbst erstellen, und so Lizenzproblemen aus dem Weg gehen. Und sie sind kommerziell erfolgreich genug, um Lizenzen für Inhalte kaufen zu können. Letzteres werden sie nützen, um auf Rechtssicherheit zu beharren, Regelungen einzufordern – und neue Mitbewerber aus dem Markt zu klagen.

Aus einer Habsburg-KI, die sich nur im eigenen Kreis vermehrt, wird so eine Mann im Mond-KI, die sich selbstgenügsam allein unterhält – und einen großen Vorsprung hat.

Das sind schlechte Aussichten für Wettbewerb und Innovation, die deutlich schlechtere Bedingungen für die Entwicklung und den Test neuer Ansätze schaffen. Tendenzen dazu sind bereits festzustellen. Microsoft ist auf Einkaufstour und hat sich mit Mistral mögliche europäische Konkurrenten einverleibt, mit DeepMind-Gründer Mustafa Süleyman auch noch einen eher kritischen AI-Evangelisten dazu. Google startet eine Reihe von branchenspezifischen Initativen – etwa im Medienbereich – um AI unter Unternehmen zu bringen. Meta hat mit Llama sogar einen Flirt mit Open Source am Laufen.

AI-Granden und theoretische Beobachter überhöhen die Bedeutung von AI ins Unermessliche. Süleyman bezeichnete AI in einem TED Talk im April als eigene Spezies, Henry Kissinger betrachtet AI in einem mit Ex-Google-CEO Eric Schmidt verfassten Buch als Weltanschauung wie Religion oder Wissenschaft.

Beides hat seine Berechtigung in der abstrakten, ethisch oder politisch orientierten weltanschaulichen Auseinandersetzung mit KI. Die Praxis schlägt allerdings eine andere Richtung ein. Generative AI ist ein Spaß, es sind faszinierende Ergebnisse, Artificial General Intelligence, die dann auch Systemgrenzen überwindet und nicht nur Informationen liefert, sondern auch gleich danach handelt, ist eine interessantes Gedankenexperiment. In konkreten Anwendungsfällen erweisen sich die generellen und generativen Ansätze allerdings schnell als hinderlich. Sie sind teuer, sie halluzinieren mehr als kleinere Modelle und ihre Ergebnisse sind schwer kontrollier- und reproduzierbar. Transparenz- und Kontrollanforderungen (wie sie etwa auch der AI Act vorsieht) können kaum erfüllt werden, wenn man die Modelle nicht selbst entwickelt und trainiert hat. Kleinere Modelle, die vielleicht nicht alles können, aber konkrete Aufgaben schneller und sicherer erledigen, sind nach einer ersten Phase der Begeisterung heute mehr und mehr das Mittel der Wahl. Strenge Copyright-Kontrollen und andere Auflagen können aber auch die Entwicklung solcher Modelle bremsen.

Internet-Suche ist mittlerweile de facto monopolisiert, noch gibt es keine AI-Monopole.

Weniger Politik, weniger Fakten, weniger Information

Instagram drosselt politische Inhalte, es sei denn, User ändern ihre Einstellungen. Das soll gegen Desinformation helfen. Es kann auch ein ganz angenehmer Nebeneffekt sein in einer Zeit, in der PolitikerInnen Usern digital alles und mehr aus diversesten Lebensfeldern aufdrängen (auch wenn sie bei passender Gelegenheit dann doch darauf drängen, dass Privates privat bleiben möge).

Facebook hat schon länger die Präsenz von Medien im Newsfeed seiner User reduziert, in erster Linie um User länger auf der eigenen Plattform zu behalten und ihnen weniger Anreiz zu bieten, anderswo hin zu klicken.

Auf TikTok berichten zuletzt auffällig viele vorrangig amerikanische Creators, wie sauber, sicher und gut organisiert der öffentliche Raum in China wäre. Das fällt nicht unter politischen Content (zu dessen Moderation sich TikTok auch gar nicht ausdrücklich verhalten will).

Medien suchen trotzdem nach wie vor die Präsenz auf sozialen Plattformen. Etwa ein Viertel der bei den INMA Global Media Awards ausgezeichneten Projekte beschäftigt sich mit diesem Themenkreis, die Hälfte davon mit TikTok.

Social Media sind nach wie vor für junge Menschen Informationsquelle und für Medien relevante Trafficbringer – allerdings müssen letztere lernen, der Tatsache ins Auge zu sehen, dass es auch so etwas wie schlechten Traffic gibt.

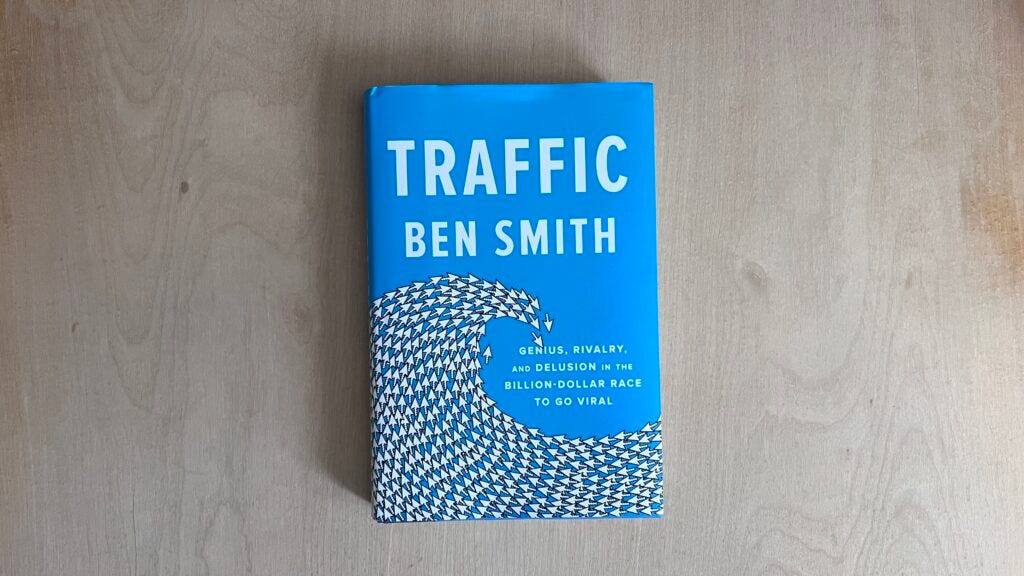

Ben Smith hat eine kurze Geschichte des Traffic geschrieben, die das erklärt – als Leiter der Nachrichtenredaktion bei BuzzFeed jemand, der er es wissen muss.

Datenschutz und Medienprivileg

Bis 20. Mai läuft in Österreich noch die Begutachtung für die Änderung zum Datenschutzgesetz, mit der Medien erweiterten Datenschutzpflichten unterliegen, aber doch noch Sonderrechte erhalten. So werden sie durch das Recht, eine Bearbeitungsgebühr zu verrechnen, vor Massenanfragen geschützt. Umgekehrt kann die Datenschutzbehörde aber prüfen, ob die Verweigerung von Auskünften unter Verweis auf Redaktionsgeheimnis und Informantenschutz tatsächlich gerechtfertigt ist.

Reaktionen bislang sind verhalten – ich schaue in der kommenden Woche öfters rein.

Ich bin Journalist, Wissenschafts- und Technologiehistoriker,

Ich bin Journalist, Wissenschafts- und Technologiehistoriker,