Es ist nichts als digitale Homöopathie und Esoterik für Statistiker, wenn wir glauben, dass uns Machine Learning-Prozesse, die wir nicht verstehen, klüger machen.

Wo fangen Algorithmen an, wo hören simple Formeln oder Kochrezepte auf? Algorithmen haben etwas Ehrfurcht gebietendes an sich, oft verwendet man das Wort, ohne allzu klar abzugrenzen, was damit eigentlich gemeint sein könnte. Das hat den Vorteil, das es phänomenal wichtig klingt, aber doch auch nicht zu vernachlässigenden Nachteil, dass es so nichts bedeutet. Es ist nicht einmal Bullshit. Rechenregeln wie simple Additionen sind Algorithmen, Kochrezepte sind Algorithmen, Wegbeschreibungen, sofern sie nachvollziehbar und für andere Menschen verständlich sind, sind Algorithmen.

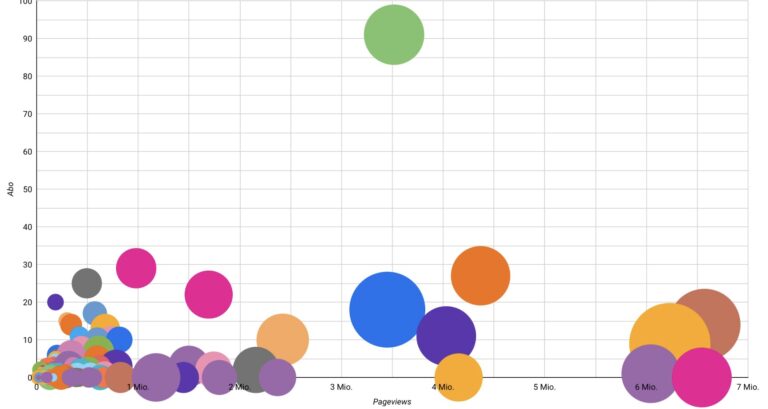

Simple Prozeduren, die zwei oder drei Messwerte kombinieren, um daraus einen neuen Indikator zu berechnen, sind erst recht Algorithmen. Aber wäre es das, was uns einfällt, wenn CEOs, Gesellschafter und andere Bosse und ihre Berater nach visionären Algorithmen verlangen, nach datadriven insights, die das Business disruptiv pushen und promoten werden?

Ein Algorithmus berechnet etwas, wenn die Berechnung im Rahmen einer Hypothese stattfindet, prüft oder testet ein Algorithmus. Die Hypothese äußert eine Vermutung, der Algorithmus sollte einen Hinweis liefern, wie weit die Vermutung zutrifft. Algorithmen ohne Hypothesen können helfen, ebensolche zu entwickeln. Sie liefern Indikatoren, aus denen Hypothesen formuliert werden können.

Das ist eigentlich schon der ganze Zauber.

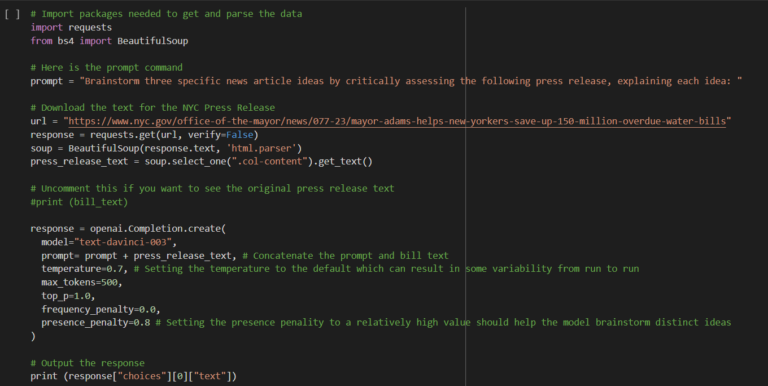

Die erste Variante beschreibt den Kern von Data Science – Behauptungen und Vermutungen werden datengestützt berechneten Ergebnissen gegenübergestellt. Das liefert Informationen über die getesteten Vermutungen und weist manchmal auch ganz neue Richtungen, an die man nicht gar nicht gedacht hätte. Die zweite Variante ist eine glamourfreie Definition von machine learning. Datensätze werden ohne konkrete Hypothesen erforscht. Die Vermutung besteht nur darin, dass diese Datensätze und die Kombination bestimmter Merkmale in ihnen etwas mit der gesuchten Antwort zu tun haben könnten. Dabei muss noch nicht einmal die Frage, auf die eine Antwort gesucht wird, besonders konkret sein.

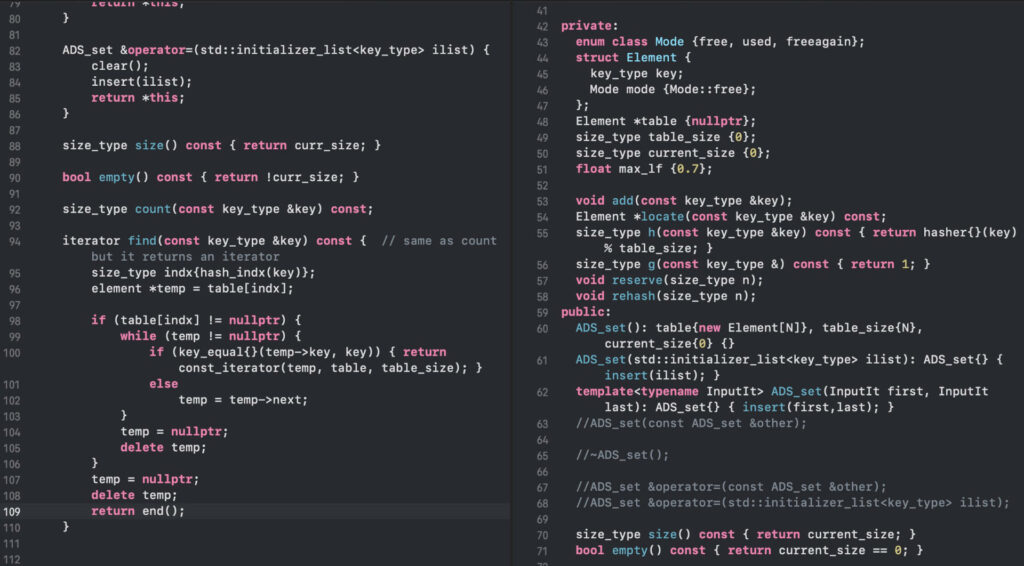

Ich befürworte es sehr, mit simplen Berechnungen zu arbeiten, die man, wären die Datensätze nicht so groß, auch mit Papier und Bleistift durchführen könnte. Natürlich macht es anders mehr Freude (und auch Sinn, wenn Parameter der Rechnung einfach verändert und die Berechnung schnell und leicht wiederholt werden kann.) Komplexität allein ist aber kein Qualitätskriterium, vor allem, wenn das die Verständlichkeit beeinträchtigt.

Vor allem machine learning Algorithmen müssen einfach sein. Wir erwarten uns neue Einsichten, die sich so nicht erschlossen hätten und auf die wir anhand der Daten allein nicht gekommen wären. Wir haben das Ergebnis also nicht unter Kontrolle, wir können nicht über richtig und falsch entscheiden. Umso wichtiger ist es, den Prozess unter Kontrolle zu haben. Wenn wir die einzelnen Berechnungsschritte nicht nachvollziehen können, haben wir keine Ahnung, wie das Ergebnis einzuschätzen ist und mit welchen Parametern es beeinflusst werden kann. Das ist digitale Homöopathie, das ist Esoterik für Statistiker.

Von einer einfachen Berechnung aus, die man nachvollziehen und auch verändern kann, kann es dann auch gern komplexer werden. Aber andersrum – wenn man also mit dem Komplexen beginnt – werden auch aus Müll keine Daten.

Das sollte das eigentliche Leitmotiv sein, wenn aus geschäftlichen Motiven nach coolen Algorithmen gefragt wird.